Aujourd’hui, je voudrais parler du coût supplémentaire du Machine Learning. Les outils ML semblent usurper l’attention des métiers de nombreuses entreprises. J’ai suivi la mise en place de modèles de prédiction de risques dans les banques, de détection de fraudes dans les multinationales, de catégorisation des produits, d’identification d’erreurs dans les factures, etc.

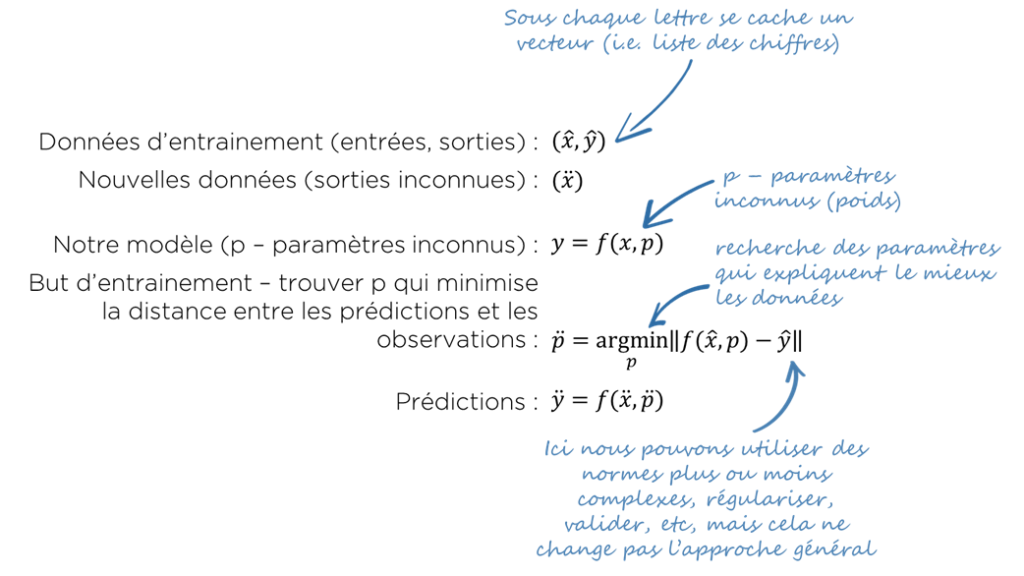

Avant de continuer, je vous propose de revenir vers le fonctionnement de « pure ML » :

- nous avons les données d’entrainement

- …et de nouvelles données pour lesquelles nous voulons obtenir les prédictions;

- nous prenons un certain modèle lambda avec des paramètres que nous pouvons ajuster;

- nous essayons de modifier ces paramètres pour obtenir le résultat le plus proche possible aux données d’entrainement;

- les paramètres obtenus sont utilisés dans le modèle pour faire les prédictions.

Le modèle reste « inconnu », i.e. nous ne savons pas vraiment pourquoi il fonctionne, pourquoi de cette manière et pourquoi pas autrement. C’est un problème d’inexplicabilité des résultats.

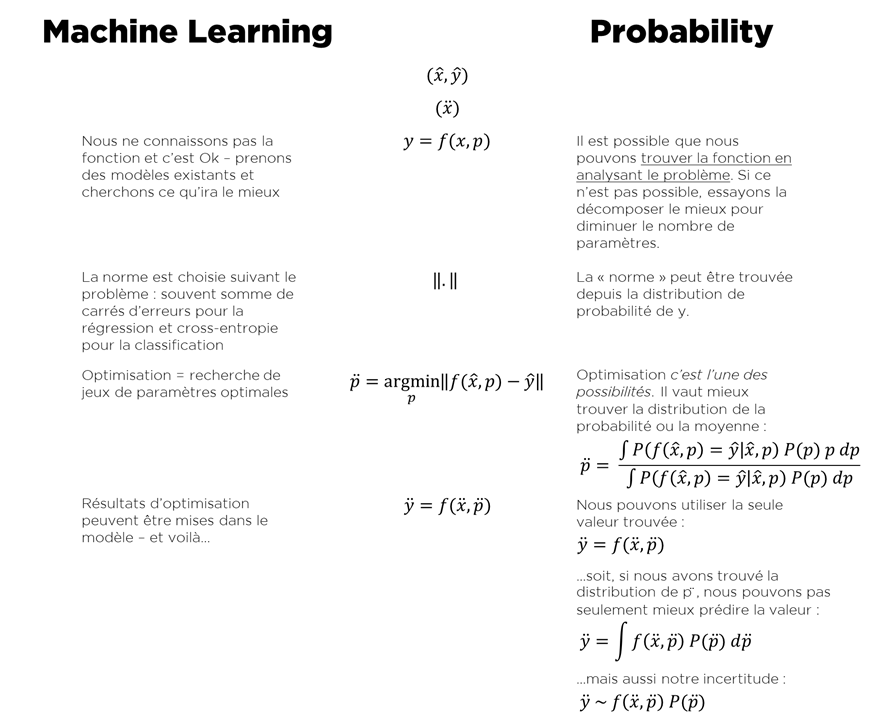

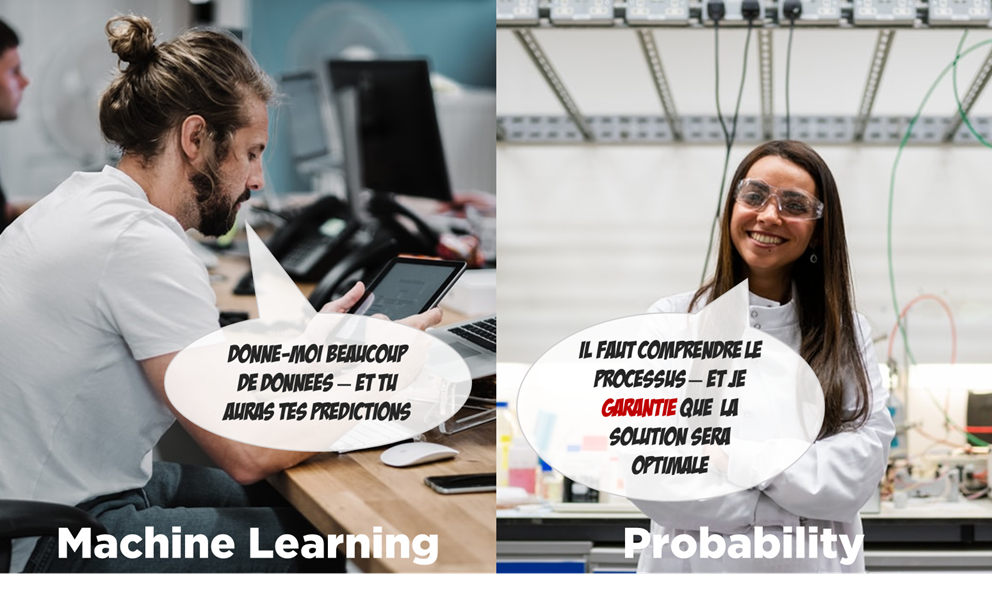

Il existe un autre chemin – plus scientifique, plus complexe – la théorie des probabilités. Voici une comparaison rapide pour des tâches de régression ou de classification :

Vous pouvez voir que la suite de la logique est semblable, mais il existe des différences. Concrètement, c’est dans la manière de s’y prendre : par rapport au modèle, les erreurs et l’optimisation.

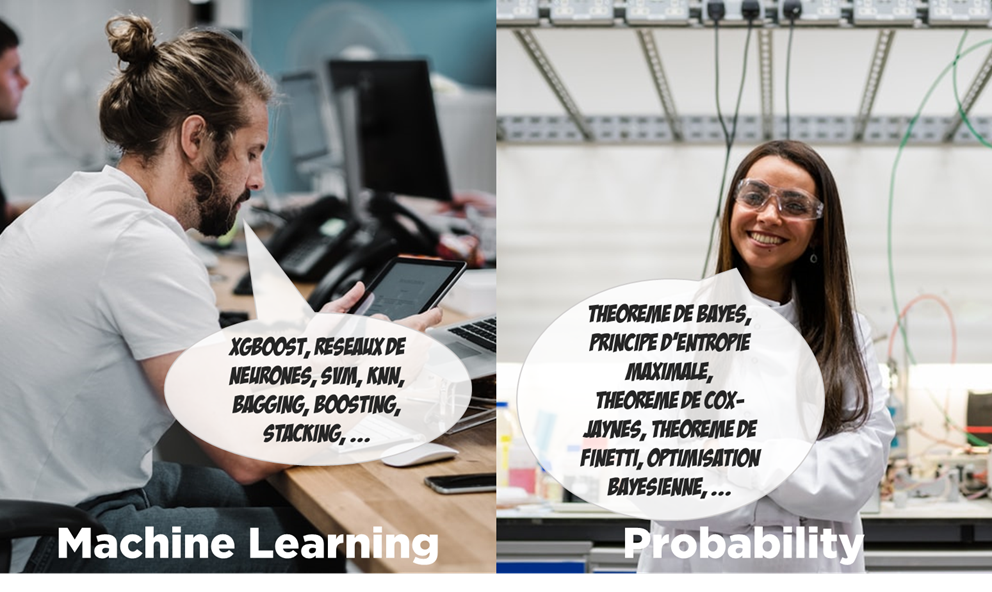

En réalité, par la loi des vases communicants, la logique « scientifique » se mélange avec la vision « pure ML ». Dans le ML, nous avons des modèles spécialisés : LSTM, transformers (mécanisme d’attention) – pour la modélisation de la langue naturelle ou des séquences, puis les réseaux convolutionnels – pour le traitement d’images… mais l’idéologie et les techniques restent très différentes.

ML c’est bien, finalement ? C’est juste inexplicable ?

Eh bien, vous pourriez avoir des mauvaises surprises :

- dans les banques, l’échec de prédiction du risque de non-paiement génère des refus de crédits dans les cas « particuliers »,

- les banques essaient d’utiliser le ML pour prédire la fermeture anticipée d’un contrat et prévoient des pénalités supplémentaires au moment de la signature (sans, en fait, savoir, pourquoi),

- les images médicales (ex. MRI) peuvent, dans le futur, ne plus se baser sur l’image obtenu et la physique des processus, mais sur les résultats fournis par un traitement basé sur un réseau de neurones,

- la grande majorité des recherches dans NLP (natural language processing) tourne autour des réseaux de neurones, donc les modèles scientifiques (ex. IBM alignment models, Probabilistic Context-Free Grammars) sont souvent délaissés,

- etc…

Si vous n’avez pas encore peur :

- lisez ce papier : https://arxiv.org/ftp/arxiv/papers/1801/1801.00631.pdf,

- … ou l’interview avec Judea Pearl (https://www.theatlantic.com/technology/archive/2018/05/machine-learning-is-stuck-on-asking-why/560675/),

- … ou regardez « Most Research in Deep Learning is a Total Waste of Time » (https://www.youtube.com/watch?v=Bi7f1JSSlh8).

Quelle est donc la conclusion ?

Je crois vraiment que la « recherche » doit être scientifique, donc je refuse d’appeler XGBoost « la science » comme cela a pu être le cas au CERN (Conseil Européen pour la Recherche Nucléaire) : https://atlas.cern/updates/atlas-news/machine-learning-wins-higgs-challenge.

Je trouve inquiétant qu’un data scientist inconnu puisse avoir le droit de créer des modèles qui font peser un risque sur de nombreux domaines de la la vie d’un citoyen lambda. En revanche, cela ne veut pas dire que nous ne pouvons pas utiliser le ML dans les domaines, où il ne peut pas faire de mal. Pensez simplement à chaque fois que le ML c’est l’outsourcing de votre compréhension de problème. C’est le prix caché que vous payez en utilisant le ML.

Je suis pour un bon mariage des approches.

Bonne santé à vous et à vos modèles.