Immature poets imitate, mature poets steal.

T.S. Eliot

Dans de nombreuses sociétés, le directeur / chef de programme BI semble se mêler dans les projets d’autres.

C’est cette personne qui as probablement lancé le sujet de Data Governance, c’est elle qui parle de nouvelles bases de données, c’est elle qui cherche à mettre en place la Data Quality, c’est assez certainement son équipe qui parlera de Data Lake ou de Stream Processing et Machine Learning, etc. C’est comme si elle n’a rien d’autre à faire !

Que se passe-t-il ?

Pour répondre à cette question, j’ai voulu retracer les liens les plus évidents entre la BI et les autres sujets de l »entreprise.

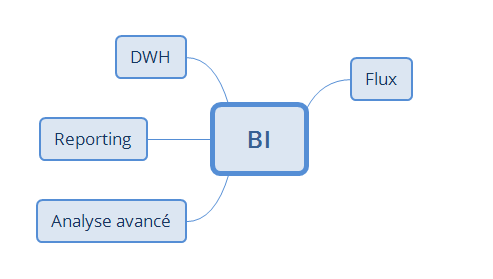

On commence par la définition des étapes de la BI (à l’ancienne) :

- constituer les analyses pour extraire les connaissances via :

- reporting,

- analyse avancé (modèles statistiques, data mining, etc),

- en passant par un entrepôt de données (DWH),

- qui se remplit avec les flux de données.

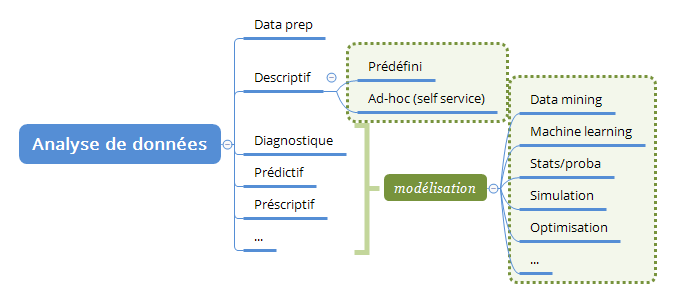

L’analyse de données est actuellement considérée comme une partie « apart », d’où les spécialisations comme la « Data Science », donc nous pouvons encore analyser cette partie :

- l’analyse « descriptif » correspond au « BI classique » avec ses rapports prédéfinis ou avec les approches plus « ad-hoc », plus « agiles » ;

- l’analyse « diagnostique », « prédictif », « prescriptif », etc – tout ce que nécessite la « modélisation » avec les différentes techniques – correspond à « l’analyse avancé de BI ».

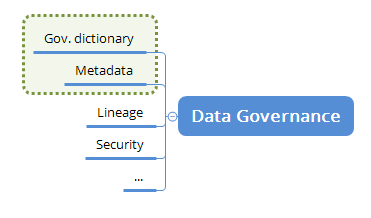

Sinon, certaines problématiques de Data Governance touchent la BI directement, notamment :

- Governance dictionaries & gestion de métadonnées (définitions des termes, data dictionaries, répertoires des règles de validation, etc),

- Lineage (suivi des flux, analyse d’impact).

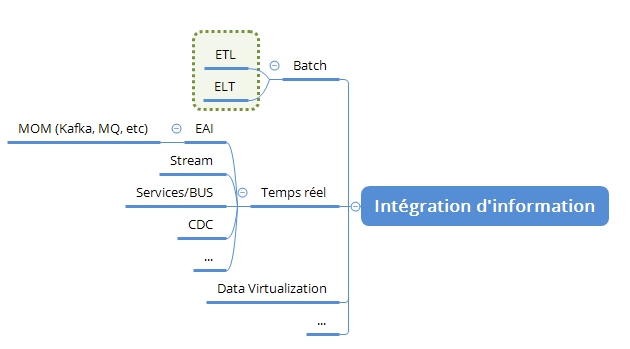

Les flux ce n’est pas quelque chose de nouveau non plus – cette notion fait partie des pratiques d’Intégration d’Information. Les flux « classiques » pour la BI sont « en batch » pour faciliter l’exploitation et la reprise, mais le CDC (Change Data Capture) est aussi un outil assez courant pour les flux BI :

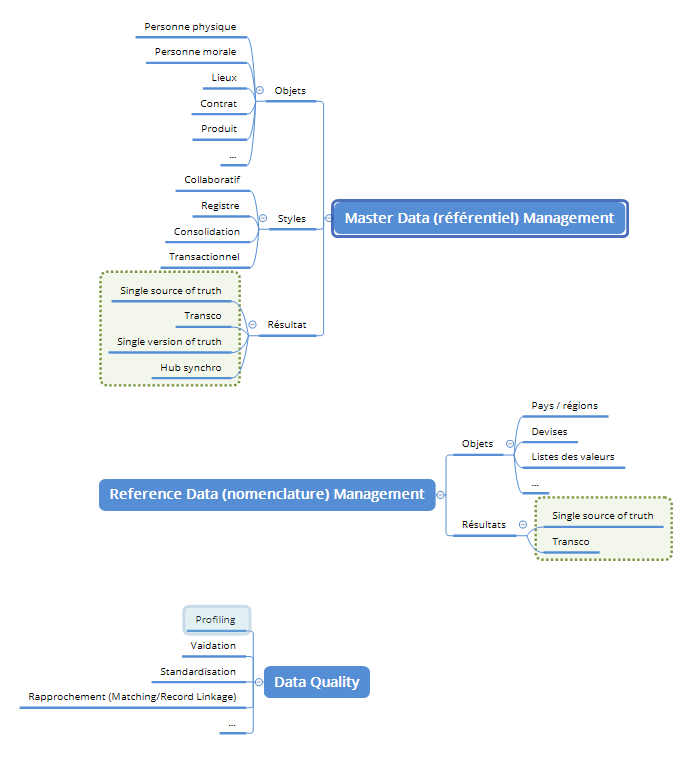

J’ai décidé de considérer séparément l’Intégration d’Information, le MDM et le RDM, mais le Master Data Management et Reference Data Management sont également directement liés au BI car la proposition de valeur du DWH est que les données sont « intégrées » et pas juste « stockées », donc MDM et RDM peuvent approvisionner DWH avec les données et les transcodifications.

En plus à MDM/RDM, Data Quality propose l’identification d’erreurs, extraction (standardisation) d’information, profiling (compréhension) de données :

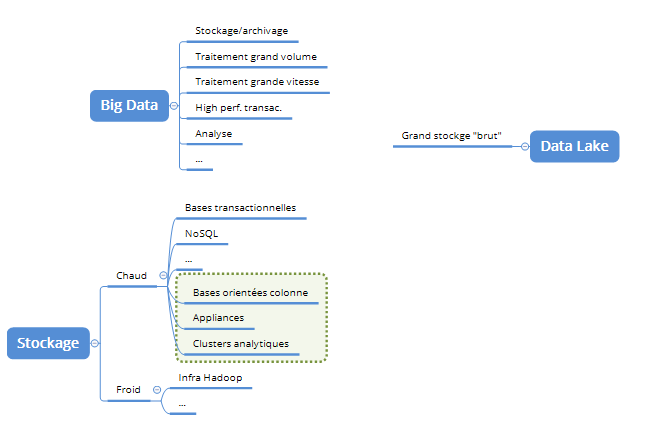

Maintenant nous arrivons à la partie encore plus technique – stockage d’information. Il est clair que l’entrepôt de données doit utiliser des bases rapides, taillées à la charge analytique, mais en plus de ce stockage « chaud », il y a du « froid » – les archives, anciennes données ou les données brutes qui peuvent aller dans le « data lake » :

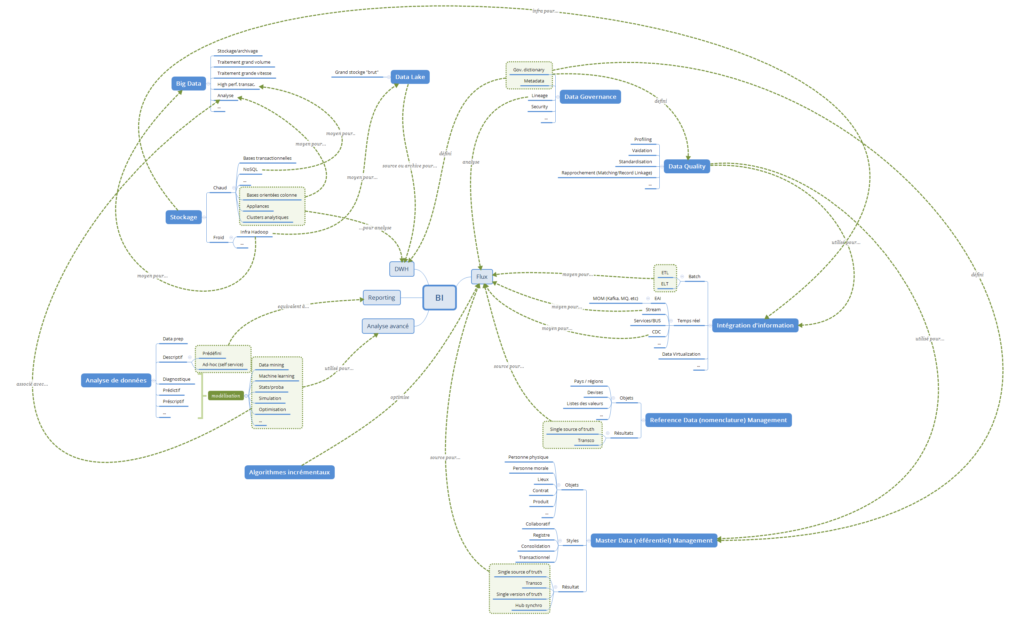

Si nous prenons juste ces briques (je ne prétends pas que la liste est exhaustive, mais suffisante pour argumenter), voici ce que nous obtenons en mettant juste les liens les plus importants :

Soit en format xMind (zippé) : BI.zip (l’outil est disponible ici : xmind.net).

Soit avec un zoom :

Vous pouvez voir que les liens sont assez denses ce que signifie que la BI a besoin de « toucher » beaucoup de sujets. Cela explique pourquoi les nombreux sujets sont lancés par une seule équipe. Par contre, cela ne veut pas forcément dire que le chef de programme BI veut être « important » – c’est juste qu’il a besoin de beaucoup de ressources pour délivrer un service de qualité.

Bonne santé à vous et à votre BI !

Pingback: Valoriser vos données en 3 étapes – Ordre d'informaticiens

Pingback: La consolidation de données : l’unification du modèle – Ordre d'informaticiens